Vooraf

Op deze blog zijn in een paar dagen tijd veel reacties gekomen, die hebben geleid tot enkele verduidelijkingen in de tekst. Vaak ook kreeg ik de vraag waar ik me druk over maak, je hebt toch niets te verbergen? Die mensen verwees ik onder meer naar de recente blog van Bert Hubert en het boek van Maurits Martijn en Rob Wijnberg.

Ik merkte in die gesprekken dat een gedachtenexperiment helpt om na te denken over de eigen afweging van publieke waarden en waar de eigen grens ligt. Dat gedachtenexperiment gaat als volgt.

Huiselijk geweld vindt meestal achter de voordeur plaats. Kindermishandeling is daarom moeilijk tijdig te detecteren. Veel mensen hebben slimme speakers in huis. Om hun lampen te bedienen, om muziek te luisteren of ingebouwd in hun televisie, bijvoorbeeld. Wat zou het handig zijn als we de bedrijven achter die speakers, zoals Apple, Amazon en Google, zouden verplichten om met de ingebouwde microfoons te luisteren naar signalen van kindermishandeling en die door te geven aan opsporingsdiensten.

Ik ben benieuwd naar jouw overwegingen.

Buikpijn over client-side scanning

Ik heb buikpijn van een onderwerp dat deze week door de Commissie Digitale Zaken in de Tweede Kamer besproken zal worden. Het onderwerp is het voorkomen van de verspreiding van kinderporno. Het lijkt iets waar je niet op tegen kan zijn. Toch ben ik dat wel. Mijn buikpijn komt door de afweging van publieke waarden die ik persoonlijk maak als het gaat om het voorstel van de EU om berichten te scannen op kinderporno voordat je deze verspreidt via bijvoorbeeld Whatsapp. Ik ben tegen dat voorstel.

Dat ik worstel met dit voorstel is een teken dat digitalisering niet (alleen) een technische aangelegenheid is. Het gaat er bij digitalisering niet alleen om, bijvoorbeeld, of kwantumcomputing bestaande beveiligingsmethoden onveilig zal maken, dat ICT ons helpt om makkelijker vakanties te boeken of studiefinanciering aan te vragen. Wat de afgelopen jaren duidelijk heeft gemaakt is dat digitalisering ook grote invloed heeft op onze samenleving. Helaas niet alleen ten goede.

Dat het mogelijk is om digitaal te bepalen of een uitkeringsgerechtigde in het buitenland verblijft, zoals het UWV deed, maakt het nog geen goed idee om dat te doen. Dat het mogelijk is om modellen te maken die fraudekans voorspellen, zoals de gemeente Rotterdam deed, maakt het nog geen goed idee om dat zo te doen dat je sommige groepen veel eerder verdenkt dan andere. Alle hulde overigens aan de Gemeente Rotterdam, die toen dat duidelijk werd ook de broncode van de gebruikte algoritmes ter beschikking stelde om er onderzoek naar te doen!

Digitalisering, kortom, heeft invloed op mensenrechten, op publieke waarden. Hoe je omgaat met de mogelijkheden die digitalisering biedt vraagt ook om een ethisch debat. Niet alles dat kan, is ook een goed idee. En, ook belangrijk, elke voorkomende situatie kun je van allerlei kanten bekijken. Er is niet een eenduidig waardenkader, waarin op volgorde van belangrijkheid de af te wegen waarden zijn opgenomen. Privacy, bijvoorbeeld, gaat niet altijd boven veiligheid. En veiligheid niet altijd boven privacy.

Welk waardenkader je gebruikt, en hoe je waarden in voorkomende gevallen weegt, kan in elke situatie anders zijn. Ook de uitkomst van de afweging kan voor iedereen, alles afwegend, anders zijn. Het is het gesprek dat telt. Daarom is het zo goed dat veel organisaties (zoals provincies en gemeenten) tegenwoordig ethische commissies instellen voor het beoordelen van digitalisering.

Vanuit de Commissie Digitale Zaken van de Tweede Kamer werd eerder de vraag gesteld:

Kunt u de concrete uitwerking van het waardenkader sturen, naar aanleiding van aangenomen motie Leijten en Ceder? Zo nee, wanneer kan de Kamer deze concrete uitwerking verwachten?

Het, wellicht teleurstellende, antwoord was toen:

Met uw Kamer deel ik de behoefte aan één duidelijk waardenkader dat toegepast kan worden in digitalisering in alle sectoren. Tegelijkertijd constateer ik dat er al meerdere waardenkaders zijn die tegelijkertijd gelden. Zo zijn de waarden die wij als maatschappij van fundamenteel belang achten vastgelegd in de Grondwet. Hierbij valt te denken aan non-discriminatie, privacy en vrijheid van meningsuiting. De bescherming van deze waarden is uitgewerkt in wetgeving. De AVG ziet bijvoorbeeld toe op de bescherming van persoonsgegevens. Op basis van deze wet- en regelgeving zijn er diverse handreikingen opgesteld om organisaties te helpen deze waarden ook in de praktijk te beschermen. Voorbeeld hiervan zijn de Impact Assessment Mensenrechten Algoritmen (IAMA), de handreiking non-discriminatie by design en de Code Goed Digitaal Openbaar Bestuur (CODIO).

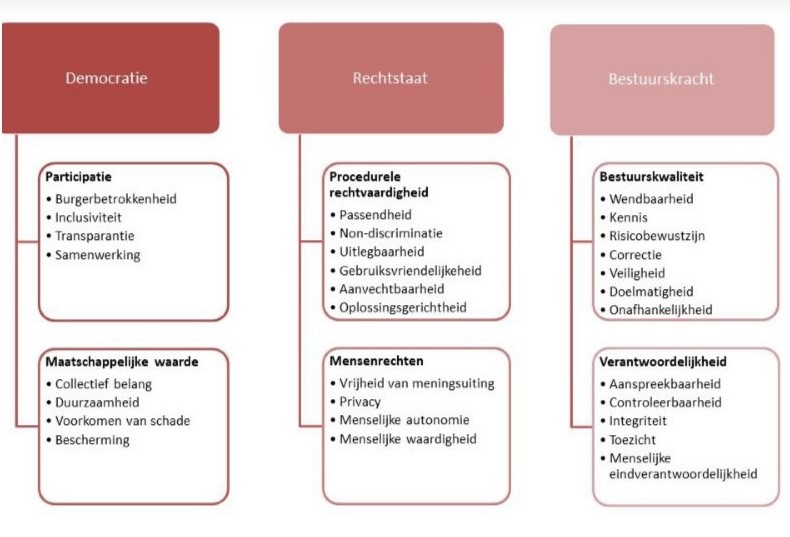

Die laatste, de CODIO, heeft 3 kernwaarden: democratie, rechtsstaat en bestuurskracht. Daaronder liggen 30 waarden, zoals non-discriminatie, uitlegbaarheid en inclusiviteit.

Ik vind het een mooi overzichtelijk kader om te gebruiken als ik een situatie van meerdere kanten probeer te bekijken. Het bevat waarden als privacy, voorkomen van schade, bescherming en veiligheid. Waarden die ook, voor mij, belangrijk zijn bij het beoordelen van het voorstel waarover de buikpijn gaat waarmee ik deze blog begon.

Het gaat over CSAM, een voorstel van de Europese Commissie voor een Verordening ter voorkoming en bestrijding van seksueel misbruik van kinderen. Een voorstel, zou je zeggen, waar je niet tegen kunt zijn. En toch bevat het elementen waarvan ik buikpijn krijg. Daarvan pak ik er één uit:

Aanbieders van hostingdiensten en aanbieders van interpersoonlijke communicatiediensten die een opsporingsbevel hebben ontvangen, voeren dit uit door technologieën te installeren en te gebruiken om de verspreiding van bekend of nieuw materiaal van seksueel misbruik van kinderen of het benaderen van kinderen, naargelang het geval, op te sporen.

Wat hier van “interpersoonlijke communicatiediensten” zoals Whatsapp, Telegram, Signal en anderen gevraagd wordt, is dat ze dat ze berichten, voordat deze worden verstuurd, moeten scannen op bekend of nieuw materiaal. Voorstanders zeggen, overigens terecht, dat hiermee de versleutelde beveiliging van de communicatie niet wordt verbroken. Want het scannen van de berichten die mensen verzenden gebeurt immers voordat deze worden versleuteld. Het is alsof je zegt dat je het briefgeheim niet verbreekt, omdat je alleen maar over de schouder meeleest voordat de envelop wordt dichtgeplakt. Feitelijk correct, maar wil jij in een digitale samenleving leven waarin big tech over je schouder meeleest met elk bericht dat je schrijft?

Artikel 13 Grondwet

Ieder heeft het recht op eerbiediging van zijn brief- en telecommunicatiegeheim.

Het voorstel voor “client side scanning”, zoals het in de volksmond is gaan heten, leidt tot allerlei inhoudelijke discussies. Of het wel mogelijk is om materiaal te herkennen bijvoorbeeld, en of communicatiediensten wel een belangrijke rol spelen bij de verspreiding van kinderporno. Voor mij is dat niet het belangrijkste, maar wel: hoe weeg je veiligheid en het voorkomen van schade af tegen privacy en autonomie. En ook: wat zijn de risico’s die eraan verbonden zijn. Risico’s die overigens niet alleen maar fictief zijn, weet de Amerikaanse vader die op verzoek van een arts een close-up van het geslachtsdeel van zijn zoontje maakte die bij Google de alarmbellen liet afgaan.

Het verbaast me dat we tech bedrijven die zich in de praktijk lang niet altijd aan onze publieke waarden houden ( waarbij we als Nederland een grote rol spelen om juist dat te beteugelen) het lezen en beoordelen van al onze communicatie toe zouden willen vertrouwen. Het verbaast me dat waar steeds meer landen gebruik van apps als TikTok verbieden we een dergelijke app wel zouden verplichten al onze communicatie te scannen. Met ook als gevolg dat zo'n app weet over wie signalen worden doorgegeven van mogelijke verspreiding van strafbaar materiaal. Best interessante informatie voor een statelijke actor.

Het voorstel vraagt overigens niet alleen vertrouwen in bedrijven, maar ook in overheden. Die immers krijgen in het voorstel alle signalen door om op te volgen. Ook daar kunnen kwaadwillenden op in spelen. Naast het herkennen van nog niet eerder gezien materiaal (dat best vaak fout zal gaan en mensen dus onterecht in een kwaad daglicht stelt en waarbij het ook niet al te moeilijk is om een beeld te maken met een andere vingerafdruk dat er toch hetzelfde uitziet) is het de gedachte dat bekend strafbaar materiaal een vingerafdruk krijgt. Communicatiediensten moeten beoordelen of die vingerafdruk aanwezig is in een bericht dat iemand wil versturen en moeten een signaal aan opsporingsdiensten geven als dat het geval is. Om iemand in een kwaad daglicht te stellen is het de uitdaging om een onschuldig plaatje met dezelfde vingerafdruk te maken. Zo'n zelfde vingerafdruk bij een ander plaatje is heel onwaarschijnlijk, maar niet onmogelijk. Net zoals het makkelijk is om door hele kleine wijzigingen aan een bekend plaatje te zorgen dat de vingerafdruk zo wijzigt dat deze niet meer herkend wordt. Jaap-Henk Hoepman schreef hier lezenswaardige blogs over.

Je begrijpt: ik heb stevige buikpijn van dit voorstel. Zoveel buikpijn heb ik niet vaak van voorstellen om digitalisering te reguleren (ik heb dat ook van het willen verbieden van anonimiteit op sociale media, maar daarover later een keer meer). Ik sta daarin niet alleen. De EDPB is kritisch, net zoals een grote groep wetenschappers en de Juridische Dienst van de Europese Commissie zelf. Die laatste vindt het een fundamentele schending van mensenrechten:

Other than the detection orders not being clear enough, the “screening of interpersonal communications” also affects “the fundamental right to respect for private life” because it gives access to interpersonal communications, such as text messages, emails, audio conversations, pictures, or any other kind of exchanged personal information.

It can also have a deterrent effect on the freedom of expression, the document says. Moreover, the data is also being processed, which “affects the right to protection of personal data.”

De afgelopen tijd voerde ik veel gesprekken over dit voorstel van de Europese Commissie. Discussies die soms erg zwart-wit werden. Maar nee, natuurlijk ben ook ik tegen het verspreiden van kinderporno! Alleen: een digitale samenleving waarin grote bedrijven moeten meelezen op alles wat ik schrijf voordat ik de envelop dicht doe, daar moet ik persoonlijk niet aan denken. Daarom heb ik buikpijn van dat voorstel. Daarom hoop ik dat we het goede ethische gesprek erover voeren. In de Tweede Kamer en in de maatschappij. En daarom hoop ik dat het uiteindelijk niet door zal gaan.

Nawoord: wat dan wel?

Het belang van het bestrijden van het maken en verspreiden van kinderporno staat voor mij buiten kijf. Die verspreiding vindt maar in beperkte mate via berichtendiensten plaats. Toch is het goed om ook daar, rekening houdend met publieke waarden, aan te doen wat kan. Voor mij zou het denkbaar zijn dat, zoals bijvoorbeeld bij antivirussoftware, de verspreiding van materiaal waarvan de strafbare aard door opsporingsdiensten is vastgesteld technisch wordt tegengegaan. Het daarna geven van een signaal aan opsporingsdiensten, met alle risico's van dien zoals hierboven beschreven, vind ik niet proportioneel.

Kortom: het voorkomen van verspreiding van eerder herkend materiaal via digitale vingerafdrukken, zonder daarvan een melding aan opsporingsdiensten te doen, zou voor mij een denkbaar compromis zijn.